1.AIと著作権の岐路 — 米国「Claude訴訟」が示す光と影

2024年、AI業界に衝撃が走りました。AmazonやGoogleといった巨大テック企業が出資するAIスタートアップ、Anthropic社が、同社の生成AIモデル「Claude」の学習に書籍を無断で使用したとして、著者らから集団訴訟を提起されたのです。

この訴訟は、OpenAIやMetaなど他の大手AI企業も直面する一連の著作権訴訟の中で、司法が具体的な判断を下した初の重要判例として、世界中の注目を集めました。そして、米連邦裁判事は米国時間2025年9月8日、15億ドル(約2200億円)規模の和解案の承認を先送りしました。

この訴訟は、日本のAI利用者が著作権リスクを考える上で、重要な示唆を与えてくれます。

本稿では、このAnthropic社の判決を概観しながら、日本の文化庁の考え方に触れ、AI利用における著作権の問題について、我々ユーザーはどのように対処すべきなのか?を検討いたします。

判決のポイント —「学習」と「保有」で分かれた判断 —

この訴訟の注目すべき点は、裁判所がAIの行為を二つに切り分け、それぞれに異なる法的評価を下したことです。

1. 「学習」は適法(フェアユース)

米カリフォルニア州連邦地方裁判所は、AIが大量の書籍データから言語のパターンや構造を学習する行為そのものについて、著作権法上の「フェアユース(公正な利用)」が成立すると判断しました。

判事は、このプロセスを人間が読書を通じて文章技法や表現スタイルを学ぶことに例え、既存の作品を単に複製するのではなく、新たなものを生み出すための「変革的利用」であると認定したのです。

これは、AIの学習プロセスが、特定の作品の創造的表現をそのまま出力する目的ではない限り、法的に保護されうるという画期的な判断でした。

2. 海賊版データの「保有」は違法

しかし、裁判所は一方で、Anthropic社のデータ管理体制に厳しい目を向けました。

同社は、AIの学習目的とは別に、約700万冊もの海賊版書籍データを「中央ライブラリ」としてサーバー上に永続的に保存し、数百名のエンジニアがいつでもアクセスできる状態にしていました。

この行為は「変革的利用」のための一時的なプロセスとは言えず、フェアユースの範囲を逸脱した大規模な著作権侵害であると判定されたのです。

この判断により、Anthropic社は1作品あたり最大15万ドル、総額で数十億ドルにも上る損害賠償責任を負うリスクに直面し、最終的には著者団体との和解を選択することになりました。

事例から学ぶポイント

この「Claude訴訟」の判決は、単に米国の事例に留まらず、AIと著作権をめぐる問題を考えるうえで、二つの論点を浮き彫りにしました。すなわち、AIの「学習プロセスそのものの適法性」と、その学習に用いる「データセットの入手・管理方法の適法性」は、全く別の問題として分けて評価されるということです。

この考え方は、日本の著作権法における「AI開発・学習段階」と「生成・利用段階」という二段階のフレームワークにも通底しています。

たとえ日本の法律(著作権法第30条の4)によってAIの学習行為自体が広く認められていたとしても、その元となるデータの入手方法が違法(例えば、利用規約で禁止されたサイトからのスクレイピングや、海賊版と知りながらのダウンロード)であったり、管理体制に問題があったりすれば、Claude訴訟のように重大な責任を問われる可能性が生じてくるわけです。

2.日本におけるAIと著作権の基本フレームワーク

AIと著作権の問題を理解するためには、まず日本の文化庁が示している考え方の枠組みを把握することが不可欠です。

文化庁は、AIに関する著作権の問題を「AI開発・学習段階」と「生成・利用段階」という2つのフェーズに分けて整理しています。

このフレームワークは、生成AIという新しい技術の登場によって著作権法が変わったわけではなく、既存の法の原則を、技術の各段階における行為の性質に応じて適用していくという立場を明確にしたものです。

なぜフェーズを分けて考える必要があるのか?

この2つのフェーズを区別することが重要なのは、それぞれの段階で行われる行為の目的が全く異なり、その結果として適用されるべき法的ルールも異なるからです。この区別を曖昧にすると、AI利用に伴うリスクを正しく評価することができません。

AI開発・学習段階

このフェーズは、AIが膨大な量の著作物をデータとして「インプット」する段階です。

ここでの主な目的は、テキストや画像からパターンや特徴を抽出し、AIモデルを構築することにあります。

著作物を人間が鑑賞する(楽しむ)目的ではないため、著作権者の権利が一部制限される特別な規定、すなわち著作権法第30条の4が主に適用されます。

生成・利用段階

こちらは、学習済みAIが新たなコンテンツを「アウトプット」し、それを人間が利用(例:SNSへの投稿、商品のデザインに使用、ブログ記事として公開)する段階です。

このフェーズでは、生成されたコンテンツが既存の著作物と偶然似てしまう可能性が問題になります。

そのため、ここでは従来の著作権侵害の判断枠組み(「類似性」と「依拠性」の有無)が原則としてそのまま適用されることになります。

このように、インプットとアウトプットでは、法的論点が異なってきます。

したがって、AIの利用プロセスを一つの連続した行為として捉えるのではなく、法的に性質の異なる2つの段階に分解して考えることが、リスク管理の第一歩になります。

3.【AI開発・学習段階】 イノベーションを促進する著作権法第30条の4

日本のAI開発は、国際的に見て非常に有利な環境にあると言われます。

この大きな理由の一つが、著作権法第30条の4の存在です。

この条文は、2018年の著作権法改正で導入された「柔軟な権利制限規定」の一つであり、AI開発やビッグデータ解析といった技術革新を法的に後押しすることを主たる目的としています。

「思想又は感情の享受を目的としない利用」とは何か

著作権法第30条の4は、著作物の利用目的が「著作物に表現された思想又は感情を自ら享受し又は他人に享受させることを目的としない場合」には、原則として著作権者の許諾なく著作物を利用できると定めています。

ここでいう「思想又は感情の享受」とは、小説を読んで感動したり、映画を観て楽しんだり、音楽を聴いて心を動かされたりといった、作品を「鑑賞」する行為を指します。

AIの学習プロセスは、まさにこの「非享受目的」の典型例です。

AIは、画像や文章を「鑑賞」しているわけではなく、そこに含まれるピクセルの並びや単語の連なりを数値データとして処理し、統計的なパターンを抽出しているにすぎません。

これはデータ解析という技術的な目的のための利用であり、「非享受目的」に該当するため、原則として第30条の4が適用され、著作権者の許諾なく学習データとして利用することが可能となります。

ここで一つ重要な点があります。

それは、AIを使って生成したアウトプット(例えばイラスト)を最終的に人間が鑑賞する目的があったとしても、そのことのみをもってAIの「学習段階」の行為が「享受目的」だったと判断されるわけではない、ということです。

あくまで学習段階の行為そのものが享受目的かどうかが問われるため、両者は切り離して考えられます。

著作権者の利益を不当に害することとなる場合

ただ、第30条の4による利用は無制限に認められているわけではありません。

条文には、「ただし、当該著作物の種類及び用途並びに当該利用の態様に照らし著作権者の利益を不当に害することとなる場合は、この限りでない」という但し書きが存在します。

これが、AI開発者が越えてはならない一線です。

この「不当に利益を害する」かどうかの判断基準は、「その利用行為が、著作権者が本来その著作物から得られるはずだった市場での利益を奪うものかどうか」という点にあります。

以下に、この但し書きに該当する可能性が高い具体的なケースを挙げます。

ケース1:情報解析用データベース市場との衝突

世の中には、AIの学習や情報解析に使いやすいように、大量のデータを整理・加工して販売されている「データベースの著作物」が存在します。

もし、このような市販のデータベースを無断で丸ごと複製し、自社のAI学習に利用した場合、それはデータベース販売者の正当な市場と直接競合し、その利益を奪う行為にほかなりません。

このようなケースは、但し書きに該当し、違法と判断される可能性が極めて高いと考えられています。

具体的な判断は最終的に司法の場でなされるものであるが,例えば,大量の情報を容易

に情報解析に活用できる形で整理したデータベースの著作物が販売されている場合に,当

該データベースを情報解析目的で複製等する行為は,当該データベースの販売に関する市

場と衝突するものとして「著作権者の利益を不当に害することとなる場合」に該当するも

のと考えられる。

出典:文化庁HP デジタル化・ネットワーク化の進展に対応した柔軟な権利制限規定に関する基本的な考え方(著作権法第30条の4,第47条の4及び第47条の5関係)https://www.bunka.go.jp/seisaku/chosakuken/hokaisei/h30_hokaisei/pdf/r1406693_17.pdf

ケース2:海賊版と知りながら学習データに利用する行為のリスク

先に触れたClaude訴訟の教訓とも重なりますが、海賊版サイトからダウンロードしたデータなど、著作権を侵害して作成されたと知りながら、それをAIの学習データとして利用する行為は非常に高いリスクを伴います。

これは文化庁が公表した「考え方について」の中でも指摘されています。

AI 開発事業者や AI サービス提供事業者が、ウェブサイトが海賊版等の権利侵害複

製物を掲載していることを知りながら、当該ウェブサイトから学習データの収集を行った

という事実は、これにより開発された生成 AI により生じる著作権侵害についての規範的

な行為主体の認定に当たり、その総合的な考慮の一要素として、当該事業者が規範的な

行為主体として侵害の責任を問われる可能性を高めるものと考えられる

出典:文化庁HP AI と著作権に関する考え方について

https://www.bunka.go.jp/seisaku/bunkashingikai/chosakuken/pdf/94037901_01.pdf

データの出所の適法性は、学習段階における最重要チェックポイントの一つです。

ケース3:特定の創作的表現を学習させるためのデータセット

これは非常に繊細な論点ですが、AIの学習目的が、一般的なパターンを学ぶことではなく、特定のクリエイターの画風や作風といった「創作的表現」そのものを模倣することにある場合、問題が生じる可能性があります。

例えば、特定のイラストレーターの作品群のみを集中的に学習データとして利用するようなケースです。このような場合、それはもはや単なる情報解析ではなく、そのクリエイターの表現を享受し、模倣するという目的が併存しているとみなされ、第30条の4の保護対象外となる可能性があると文化庁は指摘しています。

この考え方は、特定のスタイルを模倣するAIモデルの開発において、特に注意すべき点と言えるでしょう。学習データの収集意図そのものが、法的な評価に影響を与えうるということです。

アのとおり、「作風」が共通すること自体は著作権侵害となるものではない。

他方で、アイデアと創作的表現との区別は、具体的事案に応じてケースバイケースで判

断されるものであるところ、生成 AI の開発・学習段階においては、このような特定のクリ

エイターの作品である少量の著作物のみからなる作品群は、表現に至らないアイデアの

レベルにおいて、当該クリエイターのいわゆる「作風」を共通して有しているにとどまら

ず、創作的表現が共通する作品群となっている場合もあると考えられる。このような場合

に、意図的に、当該創作的表現の全部又は一部を生成 AI によって出力させることを目

的とした追加的な学習を行うため、当該作品群の複製等を行うような場合は、享受目的

が併存すると考えられる。

出典:文化庁HP AI と著作権に関する考え方について

https://www.bunka.go.jp/seisaku/bunkashingikai/chosakuken/pdf/94037901_01.pdf

このように、著作権法第30条の4は日本のAI開発に大きな自由をもたらしていますが、それは決して無条件ではありません。

「市場との衝突」「データの適法性」「学習の意図」といった点に注意を払い、但し書きの規定を遵守することが、この恩恵を享受するための前提条件となります。

4.【生成・利用段階】— 著作権侵害の判断基準

生成・利用段階の判断基準

AIの開発・学習段階を無事にクリアしたとしても、それで著作権上の問題・リスクがなくなるわけではありません。むしろ、多くのユーザーが直面する問題は、学習済みAIを利用してコンテンツを生成し、それを公開・販売する「生成・利用段階」で発生します。

そして、この段階の行為は、著作権法第30条の4の保護対象外です。

例えば、AIが生成したコンテンツが、既存の誰かの著作物と似ていた場合、その利用行為は通常の著作権侵害の枠組みで判断されることになります。

AIを利用して生成した画像等をアップロードして公表したり、複製物を販売したりする場合の著作権侵害の判断は、著作権法で利用が認められている場合※を除き、通常の著作権侵害と同様

※ 個人的に画像を生成して鑑賞する行為(私的使用のための複製)等

出典:文化庁HP AIと著作権の関係等について https://www8.cao.go.jp/cstp/ai/ai_team/3kai/shiryo.pdf

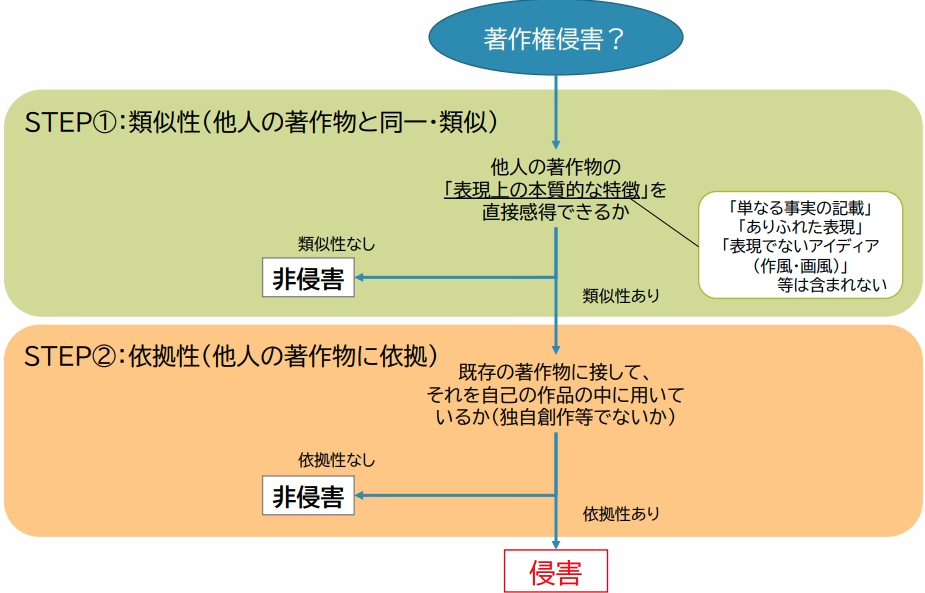

著作権侵害が成立するかどうかを判断する上で、鍵となるのが「類似性」と「依拠性」という二つの要件です。AI生成物が既存の著作物と①「類似」しており、かつ②それに「依拠」して作られたと認められる場合に、著作権侵害が成立します。

生成された画像等に既存の画像等(著作物)との類似性

(創作的表現が同一又は類似であること)や依拠性(既存の著作

物をもとに創作したこと)が認められれば、著作権者は著作権侵

害として損害賠償請求・差止請求が可能であるほか、刑事

罰の対象ともなる

出典:文化庁HP AIと著作権の関係等について https://www8.cao.go.jp/cstp/ai/ai_team/3kai/shiryo.pdf

「類似性」の判断:アイデアと表現の境界線

まず「類似性」ですが、これは単に雰囲気やテーマが似ているだけでは認められません。

著作権が保護するのは、具体的な「創作的表現」であり、アイデアやコンセプト、あるいは画風や作風といった抽象的なスタイルそのものではないからです。

裁判における類似性の判断基準は、後発の作品(この場合はAI生成物)から、既存の著作物の「表現上の本質的な特徴を直接感得できるか」どうか、という点にあります。

例えば、画像生成AIに対して「未来都市をサイバーパンク風に描いて」と指示して生成されたイラストが、ある特定のSF映画のワンシーンと背景のビル群の配置やキャラクターのデザインまで酷似していた場合、それは「表現上の本質的な特徴」が共通しているとして類似性が認められる可能性が高いでしょう。

一方で、単に「〇〇先生の画風に似ている」というだけでは、具体的なキャラクターや構図が一致しない限り、通常はアイデアの模倣とされ、類似性は否定されます。

AI時代における最大の難問:「依拠性」の解釈

著作権侵害が成立するためのもう一つの要件が「依拠性」です。

文化庁の資料によれば、依拠性とは「既存の著作物をもとに創作したこと」を意味します 。

たとえ結果的にそっくりな作品が生まれても、それが既存の著作物を知らずに偶然一致したに過ぎない「独自創作」である場合は、依拠性はないとされ、著作権侵害にはなりません。

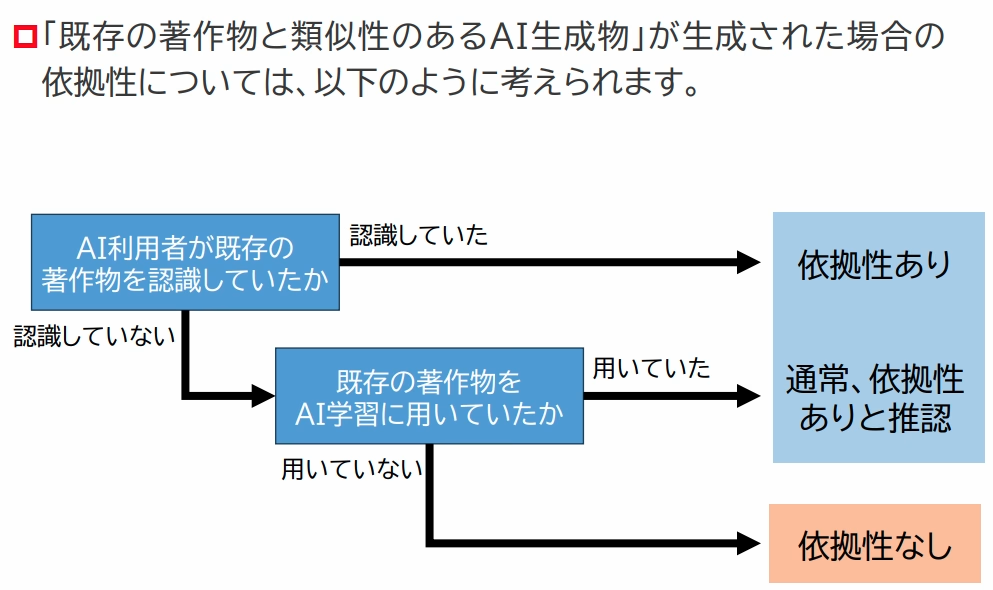

この依拠性の判断が、AIの登場によって極めて難解な問題となっています。

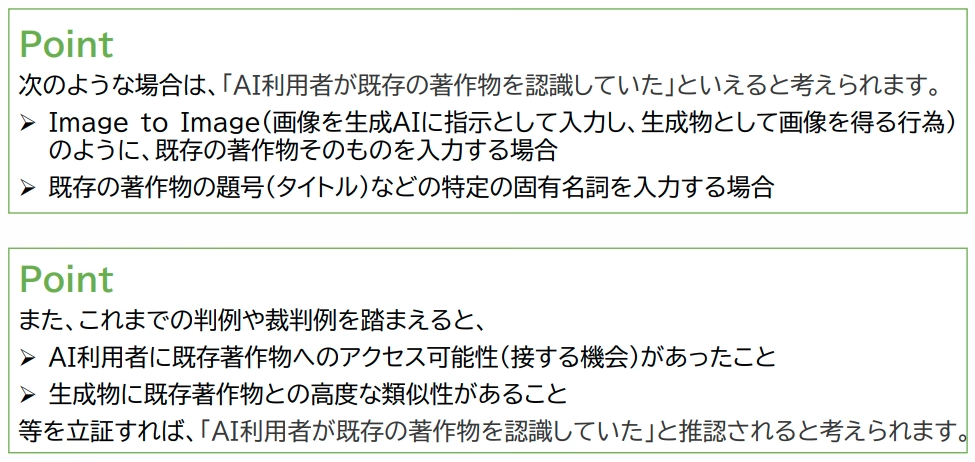

なぜなら、AIの利用プロセスでは、プロンプトを入力する「AI利用者」と、実際に画像を生成する「AIモデル」という主体が分かれるからです。文化庁もこの点を重要な論点として認識しており、AI利用者が元の著作物を全く知らなかったとしても、AIモデルがその著作物を学習データとして過去に読み込んでいた場合に、法的に「依拠した」ことになるのか、という問いに対する明確な法的判断はまだ定まっていません 。

この難問に対し、文化庁はいくつかの考え方や類型を整理しつつ、引き続き検討が必要な課題としています 。

文化庁が示している考え方を踏まえると、例えば「AI利用者が既存の著作物を認識しておらず、かつ、AIの開発・学習段階で当該著作物を学習していなかった場合」に類似した生成物が生まれても、それは偶然の一致として依拠性は認められないと考えられます 。

しかし、問題が複雑になるのは、AI利用者が元の著作物を知らなくても、AIがそれを学習していたケースです。この点について、文化庁は特定の結論を示していませんが、専門家の間では様々な見解が議論されています 。

例えば、「元の著作物がAIの学習に用いられていれば、依拠性を認めてよい」という見解や、「AI生成物が元の著作物と著しく類似している場合は、依拠性があると推定し、AI利用者側がそうではないことを証明すべき」といった考え方が示されています 。

現状、これらのどの見解が法的に正しいのか、裁判所の判断はまだ定まっておらず、文化庁も今後の検討課題としています 。この法的な不確実性は、AIをビジネスや創作活動で利用する上での最大のリスク源と言えるでしょう。

特に、生成物が既存の作品と酷似してしまった場合、たとえ利用者に悪意がなくても、著作権侵害の責任を負う可能性が否定できません。このリスクを念頭に置いた上で、利用者は慎重な対応を迫られることになります。

出典:文化庁HP A I と著作権 Ⅱ より抜粋https://www.bunka.go.jp/seisaku/chosakuken/pdf/94097701_02.pdf

出典:文化庁HP A I と著作権 Ⅱ より抜粋https://www.bunka.go.jp/seisaku/chosakuken/pdf/94097701_02.pdf

出典:文化庁HP A I と著作権 Ⅱ より抜粋https://www.bunka.go.jp/seisaku/chosakuken/pdf/94097701_02.pdf

5.AI生成物は誰のものか? — 著作物性の判断

AIを利用してコンテンツを生成する際、多くの人が抱く素朴な疑問は「この生成物の著作権は誰にあるのか?」というものでしょう。

この問題の答えは、AIと人間の関与の度合いによって決まります。

著作権が発生するための要件:「人間の創作的寄与」

日本の著作権法では、著作物は「思想又は感情を創作的に表現したもの」と定義されています。

この定義の根幹には「人間による創作」という思想があります。AI自体はプログラムであり、思想や感情を持たないため、AIが完全に自律的に生成したコンテンツには、原則として著作権は発生しないと考えられています。

この考え方は国際的にも共通しており、例えば米国では、スティーブン・セイラー氏が開発したAI「DABUS」が自律的に生成したアート作品「A Recent Entrance to Paradise」について著作権登録を申請しましたが、「人間の著作者が存在しない」ことを理由に、著作権局および裁判所によって却下されています。

AI生成物に著作権が認められるためには、その生成プロセスにおいて「人間の創作的寄与」があったと評価されることが必要です。

つまり、人間が単なるAIの「オペレーター」にとどまらず、創作の主体として、その思想や感情を表現するためにAIを「道具」として使いこなしたと言えるかどうかが問われるということになります。

「創作的寄与」はどこで判断されるか?

では、具体的にどのような行為が「創作的寄与」と認められるのでしょうか。明確な線引きは難しいものの、文化庁の考え方などを参考にすると、以下のように整理できるのではないでしょうか。

創作的寄与が認められにくい例

「赤いリンゴの絵を描いて」といった、誰が入力しても同様の結果になるような、ありふれていて短いプロンプトを与えただけで、あとはAIが自動的に生成した場合。この場合、人間の創作的な関与は極めて乏しいと判断され、生成物に著作物性は認められない可能性が高いと考えられます。

創作的寄与が認められる可能性のあるケース

- プロンプトにおける創作性

人間の創作意図(例えば、特定のテーマや感情、世界観)をAIに伝えるために、プロンプトに具体的な指示を詳細に記述し、何度も試行錯誤を重ねて調整した場合。

プロンプト自体に創作性が認められるほど、生成物にも人間の寄与が反映されていると評価されやすくなると考えられます。 - 生成プロセスにおける選択・指示

AIに複数のバリエーションを生成させ、その中から自身の創作意図に合致するものを選択し、さらに「この部分の色を変えて」「もっと悲しい表情にして」といった具体的な修正指示を繰り返し与えることで、最終的な生成物に人間の意図が強く反映された場合。 - 生成後の加筆・修正

AIが生成した画像や文章をあくまで「素材」や「下書き」として扱い、人間がその上から大幅な加筆、修正、編集を加えて、新たな創作的表現を付け加えた場合、少なくとも人間が手を加えた部分については、その人の著作物として保護されると考えられています。

6.AI利用者が講じるべき実践的リスク管理策

これまでの分析を踏まえ、次はビジネスパーソンが日々の業務の中でAIを安全に利用するために、明日から実践できる具体的なリスク管理策を、4つの階層に分けてご提案します。

これらの対策を組み合わせることで、著作権侵害のリスクを低減させることができるはずです。

1. 入力段階 プロンプトレベルでの対策

AIに指示を与えるプロンプト段階からリスク管理を意識します。

- 特定の作家名・作品名の使用を避ける

「〇〇先生の画風で」「映画『△△』のような雰囲気で」といった、特定の固有名詞を含むプロンプトは、生成物がその作品に似てしまった場合に「依拠性」があったと認定される強力な証拠となり得ます。

このような直接的な指示は避けた方が良いでしょう。 - 作風を「要素」に分解して指示する

特定の作家名に頼るのではなく、表現したいスタイルを具体的な言葉で要素分解して指示するとリスクを下げることができます。

例えば、「淡く透明感のある水彩画のようなタッチで、光の表現を強調して」「未来的で、クロームメッキのようなメタリックな質感のキャラクター」といった指示は、具体的でありながら特定の著作物への依拠性を弱める効果があります。 - オリジナリティを要求する

プロンプトの中に、「既存の作品やキャラクターを複製しないでください」「オリジナルのデザインを生成してください」といった一文を加えることも、リスク低減の一つの方法です。

これはAIに対する指示であると同時に、利用者自身が著作権を意識していることの記録にもなります。

2. 出力段階 生成物レベルでの対策

AIからのアウトプットを鵜呑みにせず、必ず人間の目でチェックするようにします。

- 類似性チェックの実施

生成されたコンテンツが、既存の著作物と酷似していないかを確認するようにします。画像であればGoogleレンズなどの画像検索ツール、文章であればコピーコンテンツチェックツールなどを活用することで、意図しない類似を早期に発見することができます。 - AI生成物を「たたき台」として利用する

AIの出力をそのまま完成品として公開・販売するのではなく、あくまでアイデア出しの「たたき台」や「素材」として活用することが重要な対策になります。

人間の手で大幅な編集、加筆、修正を加えるようにすると、元の生成物との依拠性を断ち切ると同時に、人間による「創作的寄与」が明確になり、自身の著作物として主張する根拠も生まれます。

3. 環境構築段階 ツール・サービス選定レベルでの対策

どのAIサービスを選ぶかという段階も重要です。

- 学習データの透明性が高いサービスの選定

どのようなデータセットでAIモデルを学習させたかを公表している、信頼性の高いサービスを選ぶべきです。学習データの出所が不明なサービスは、潜在的なリスクを抱えています。 - 権利処理済みデータを利用したサービスの選定

Adobe社の「Firefly」のように、学習データをAdobe Stockなどのライセンス契約済みの素材や、著作権が消滅したパブリックドメインの作品に限定しているサービスは、生成物が第三者の著作権を侵害するリスクが極めて低いと言えます。

4. ガバナンスの段階 組織レベルでの対策

最後はルール作りの段階です。

個人利用にとどまらず、企業としてAIを導入する場合には、このルール作りが必要になります。

- 社内AI利用ガイドラインの策定

全従業員が遵守すべき統一ルールを策定します。

ガイドラインには、①利用を許可するAIツールとサービスの一覧、②会社の機密情報や個人情報をプロンプトに入力することの禁止、③生成物の商用利用時のレビュー・承認プロセス、④著作権侵害が疑われる場合の報告手順などの明記が考えられます。 - 従業員へのリテラシー教育の実施

ガイドラインを作成するだけでなく、著作権の基本的な考え方、AI利用に伴う具体的なリスク、社内ルールの内容について、定期的な研修を実施し、従業員一人ひとりのリスク意識を高めることが、組織全体のリスクを管理する上で欠かせないでしょう。

これらの対策を多層的に講じることで、法的な懸念を最小限に抑えながら、AIを安全に活用することが可能になります。

最後に:今後の法改正と技術の動向

AIと著作権の問題は、インターネットという特性上、一国の法制度だけで完結するものではありません。EU、米国、中国といった主要国の法制度や判例の動向が、日本の議論や企業のグローバルな事業展開に大きな影響を与えると考えられます。

そんな中、日本が著作権法第30条の4によってイノベーション促進を重視する比較的柔軟な姿勢を取っているのに対し、EUでは「AI法」の制定などを通じて、学習に用いた著作物の概要を開示する透明性義務を課すなど、より権利者保護に重きを置いた規制を導入する動きがあります。

また、米国ではClaude訴訟のように、個別の訴訟を通じてケースバイケースでフェアユースの範囲を画定していくアプローチが取られています。

このように法制度が各国で異なっている状況は、グローバルにサービスを展開する企業にとって悩みの種になるでしょう。

例えば、日本の法律に準拠して適法に開発されたAIモデルであっても、EU市場でサービスを提供する際には、EUの厳しい透明性義務やオプトアウトの要請に対応できなければ、違法と判断されるリスクがあります。したがって、結果的に最も規制の厳しい地域のルールに合わせて開発せざるを得なくなる可能性も否定できません。

AIと著作権をめぐる法的状況は、まだ発展途上にあり、多くの論点が残されています。AIの急速な進歩に法整備が追いついていないのが現状なので、日常的にAIを活用される方はこれからの動向に注目し続ける必要があります。